AI 모델이 점점 더 거대해지면서 자연스럽게 운영 효율에 대한 문제가 부각되었습니다. GPT-4 같이 거대한 인공지능 모델은 메모리를 많이 차지하고, 느리며, 전력 소모가 심하다는 문제가 있습니다. OpenAI의 샘 알트먼은 최근 “AI의 전력 소모량이 예상을 초월한다”며 핵융합 등 에너지 산업의 혁신이 필요하다고 발언 할 정도입니다. 전세계 사용자들을 대상으로 대규모 서비스를 하려면 이러한 문제는 반드시 해결되어야 합니다. MS가 이번에 발표한 Bitnet B1.58은 이러한 운영 효율을 크게 개선했습니다.

누구나 이해할 수 있는 Bitnet B1.58

딥러닝 모델은 가중치(Weights)라는 숫자들로 구성되어있습니다. 이 가중치는 일반적으로 긴 자릿수의 실수 값으로 저장되어있고, 이 숫자들에 입력값을 곱하고 더하면서 결과를 계산합니다.

이 실수 값의 자릿수가 길어질수록 좋은 성능을 낼 수 있지만, 메모리 사용량이 늘어납니다. 그래서 AI업계에서는 자릿수를 줄이면서, 성능을 보존하는 방법을 연구해 왔습니다.

이것이 이번에 MS가 공개한 Bitnet B1.58(이하 B1.58)의 가중치입니다. B1.58은 자릿수를 극단적으로 줄여서 오직 -1, 0, 1로만 가중치를 저장합니다. 이렇게 간단한 방식으로 저장을 하면, 메모리 사용량과 연산량을 모두 줄일 수 있습니다. 기존에는 가중치를 너무 간단하게 저장하면 성능 하락이 심해서 활용하기가 어렵다는 문제가 있었는데, B1.58은 메모리 사용량을 크게 줄이면서, 성능이 유지되거나 오히려 더 잘 나왔다고 합니다.

얼마나 좋아진 걸까?

우선 속도가 크게 개선되었습니다. 파란색은 Meta에서 공개한 언어모델 LLaMA이고 주황색은 B1.58입니다. 수를 저장하고 계산하는 방법을 효율적으로 만들면서 속도도 3배가량 빨라졌습니다. 모델 크기가 커질수록 LLaMA에 비해 더 큰 폭으로 빨라집니다.

마찬가지로 메모리 사용량도 크게 줄었습니다.

가장 놀라운 점은 에너지 소모입니다. B1.58은 LLaMA에 비해 수십 배 적은 에너지를 소모합니다. 이는 B1.58은 가중치를 정수로만 저장하는데, 정수의 연산이 실수의 연산보다 에너지 소모가 훨씬 적기 때문에 이런 놀라운 결과가 나올 수 있었습니다.

실제로 어떤 변화가 체감 될까?

메모리도 적게 소모하고, 전력 효율도 좋아진 것이 좋긴한데, 이런 기술이 개인 사용자들에게는 어떤 것들이 좋아질까요?

우선 개인의 PC에서는 사용하기 어려운 거대한 언어 모델이나 동영상 생성 모델 등의 진입장벽이 더 낮아질 것입니다. 또한 사양이 더 낮고, 전력을 효율적으로 사용해야하는 스마트폰에서도 AI 모델을 활용하기 더 수월해질 것입니다. 서버에 의존하지 않고 온디바이스로 작동하는 기능들이 더 많아질 것입니다.

또한 언어모델의 활용도가 더 높아질 것입니다. 언어모델의 프롬프트를 길게 넣을 수 있으면 책 한권을 통채로 요약하는 등의 작업이 가능합니다. 언어모델이 긴 프롬프트를 기억할수록 메모리 사용량이 많아져서, 프롬프트 길이에 제한이 있었는데, 1.58B 같은 기술을 통해 메모리 사용량을 절약한다면 그만큼 더 긴 프롬프트를 지원할 수 있게 됩니다.

하드웨어도 함께 발전한다.

AI는 소프트웨어와 하드웨어가 함께 발전하고 있습니다. 이번에 B1.58이 소프트웨어적으로 성과를 거두었다면, 앞으로 이런 새로운 방식에 최적화된 하드웨어가 등장할 것입니다. 여러 분야의 발전들이 곱하기로 적용된다면 AI는 모두의 생각보다 더 빠르게 발전할 것입니다.🪐

인간의 상상력을 뛰어넘는 인공지능!

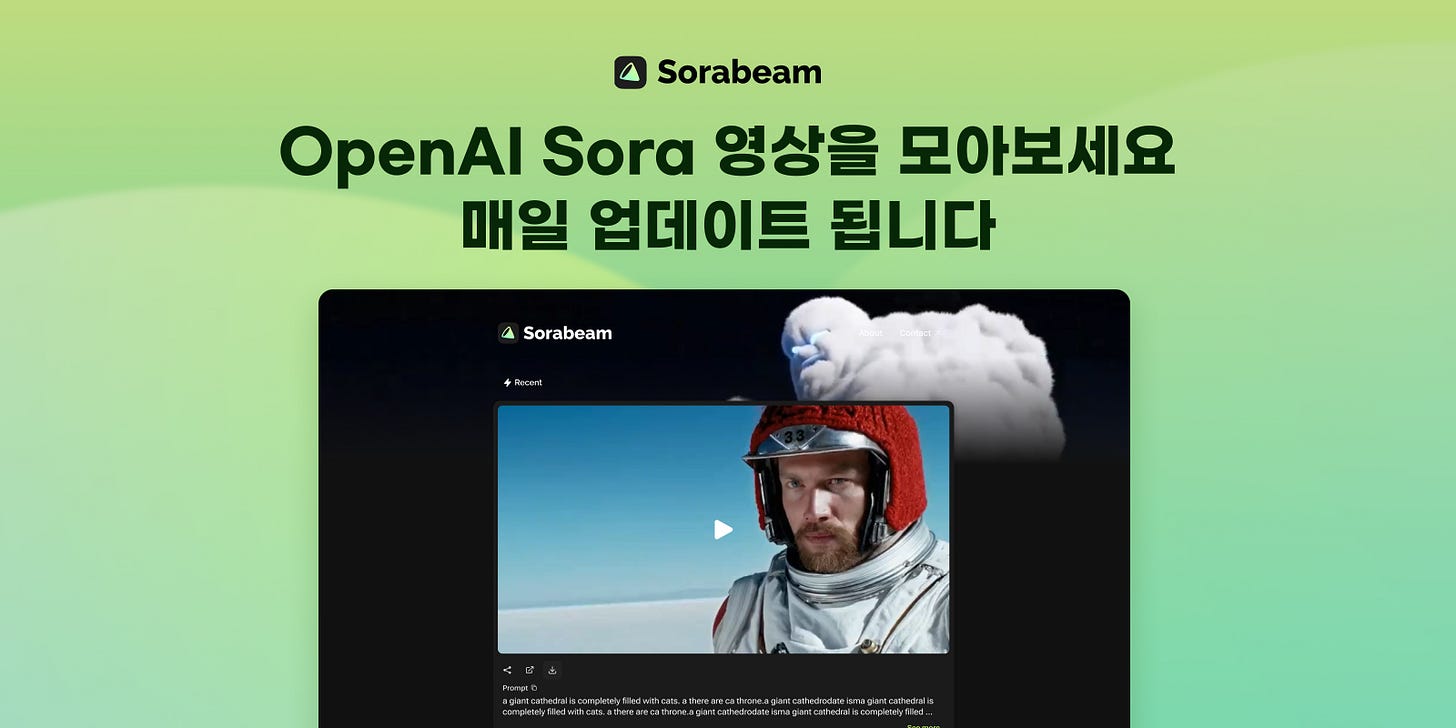

sorabeam.pickyz.io 에 방문해보세요.

OpenAI의 Sora로 생성한 멋진 영상들을 감상할 수 있습니다.

지금 바로 Sora의 세계로 풍덩 빠져보세요!

정수 계산 인상깊네요!

장점이 있어서 실수로 계산하고 있을텐데 어떻게 해결했을지 궁금합니다(정수가 너무 커지는 문제 혹은 수 표현의 다양성 부족 등).